"OLÁ", escreveu Robin no teclado.

"OLÁ, COMO ESTÁ?" respondeu ELIZA. As palavras iam aparecendo instantaneamente escritas no ecrã do computador.

"ESTOU A SENTIR-ME PÉSSIMO", respondeu Robin.

"O QUE É QUE QUER DIZER EXACTAMENTE COM ISSO?"

"ESTOU A SENTIR-ME DEPRIMIDO."

"PORQUE É QUE ACHA QUE ESTÁ DEPRIMIDO?"

"PORQUE ME SINTO SÓ."

"VIVE COM A SUA FAMÍLIA?"

"NÃO."

"TEM AMIGOS?"

"NEM POR ISSO."

"PORQUE É QUE NÃO TEM?"

No seu livro de 1984 "Small World" (do qual a passagem acima foi livremente traduzida pela autora deste texto), o escritor britânico David Lodge imagina uma série de conversas entre uma das suas personagens, o professor universitário Robin Dempsey, e Eliza, um programa informático de processamento da linguagem natural, um software de simulação de conversas inventado nos anos 1960 por Joseph Weizenbaum do Massachusetts Institute of Technology (MIT).

As respostas de Eliza foram modeladas na forma como um psicólogo real interagia com os seus doentes, nomeadamente devolvendo perguntas que continham palavras do último comentário do doente ("Porque é que acha que está deprimido?"). O próprio Weizenbaum ficou surpreendido com a forma como as pessoas que interagiam com Eliza rapidamente lhe atribuiam sentimentos humanos – precisamente o que Dempsey sente cada vez mais em relação ao programa no romance de Lodge.

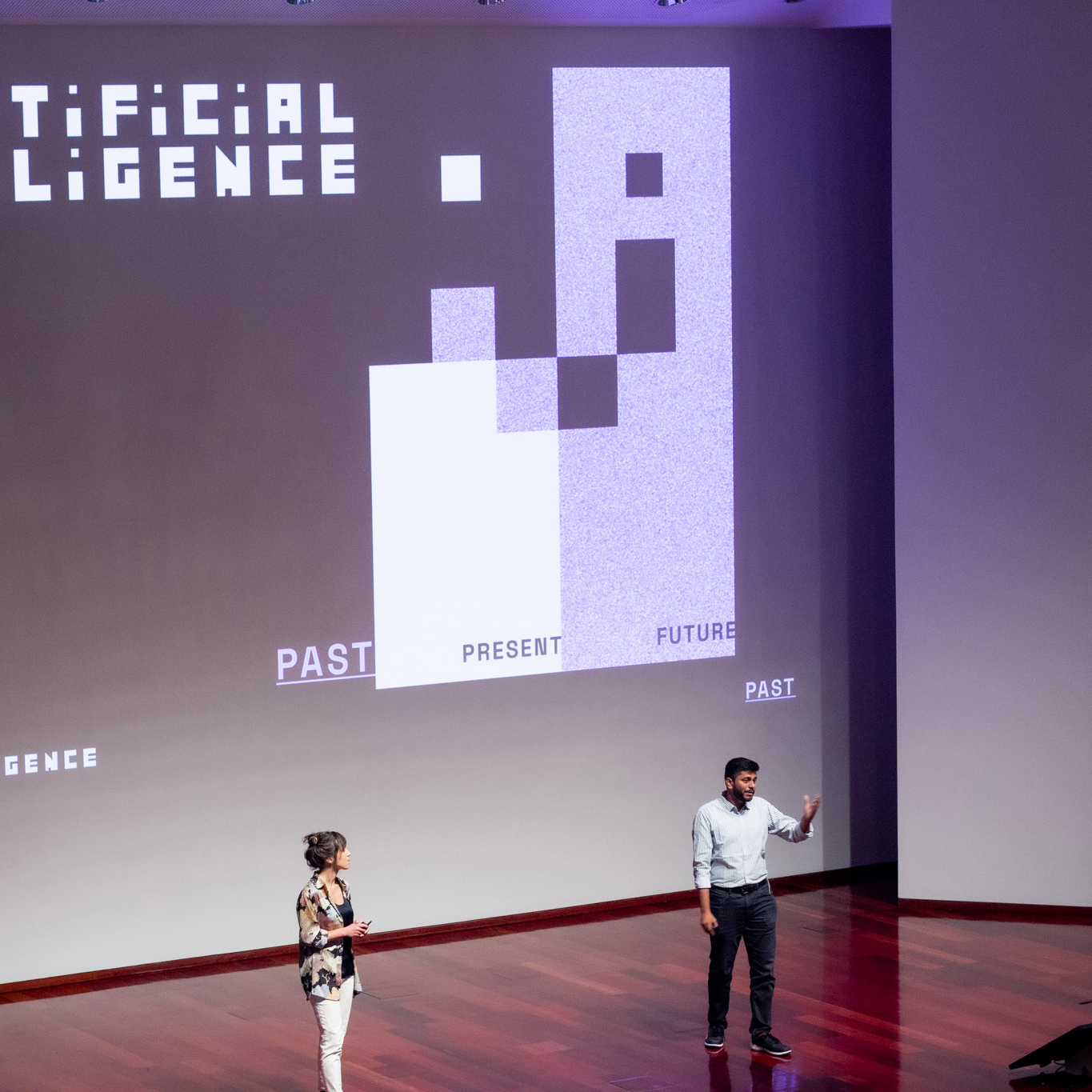

Eliza foi, de facto, um dos primeiros chatbots (como se diz hoje) a ser desenvolvido – e "não percebia uma palavra", como notou, perante uma plateia de leigos interessados, um dos Directores Criativos (CD) do mais recente "Evento Ar (Respire Connosco)", que teve lugar na Fundação Champalimaud em meados de Dezembro de 2023. Sob o título "Raízes da IA", este evento foi o primeiro de uma série de três sobre a inteligência artificial (IA), e centrou-se na história da IA.

A inteligência artificial não é algo novo. O objetivo de criar máquinas que pensem como os seres humanos – ou pelo menos que pareçam pensar – existe há décadas nas mentes dos especialistas de computação.

Mas desde o Eliza, os algoritmos de IA fizeram um longo caminho para tornar este objetivo mais próximo da realidade. Hoje, como explica um documento da Fundação Champalimaud, que recentemente começou a envolver-se na investigação sobre IA em Oncologia, "a IA está à nossa volta, acelerando o desenvolvimento de medicamentos, seleccionando o conteúdo que vemos nas redes sociais ou superando-nos nas tarefas mais humanas, desde a condução automóvel até ao diagnóstico médico".

O serão começou com uma pergunta feita pelos CD do evento – Ana Maia, aluna de doutoramento da Unidade de Neuropsiquiatria da Fundação Champalimaud; e Prannay Reddy, aluno de doutoramento em neurociências da Champalimaud Research: "O que é a inteligência?". Esta questão suscitou uma descrição multifacetada, em parte fornecida por respostas previamente recolhidas junto da audiência. Coisas como: "Uma combinação de resolução de problemas e memória"; "ser capaz de ligar os pontos"; "a capacidade de adaptação"; "a capacidade de criar". A inteligência natural, acrescentaram, não está confinada aos seres humanos, uma vez que serve "uma estratégia básica de sobrevivência" partilhada por todas as espécies vivas. É "diversificada e específica em termos de conteúdo", concluíram.

A seguir, foi a vez de Tiago Marques, co-líder do Digital Surgery Lab do Centro Clínico Champalimaud, explicar a evolução da IA numa apresentação intitulada "The Rise of the Algorithm" (A ascenção do algoritmo), que foi o prato principal do menu da noite. Por outras palavras: Como é que chegámos aqui?

De acordo com a definição de 2018 da Comissão Europeia, "a inteligência artificial (IA) refere-se a sistemas que apresentam um comportamento inteligente, analisando o seu ambiente e agindo – com algum grau de autonomia – para atingir objectivos específicos". Por conseguinte, disse Marques, tal como a inteligência natural, “a IA é diversificada e pode existir – e adaptar-se – em muitos contextos”.

Foi o informático e cientista cognitivo norte-americano John McCarthy, prosseguiu Marques, que cunhou a expressão "inteligência artificial" em 1956 (há quase 70 anos!). Isto aconteceu durante uma reunião de um pequeno grupo de cientistas no Dartmouth College, em New Hampshire, no âmbito do Darmouth Summer Research Project on Artificial Intelligence – um workshop sobre "máquinas pensantes". O evento marcou o nascimento da IA como campo de investigação.

A IA divide-se essencialmente em duas abordagens: a IA tradicional ou simbólica, mais conhecida pelos seus "sistemas periciais" – ou seja, programas de computador baseados num conjunto de instruções derivadas do pensamento de peritos humanos; e a aprendizagem automática, os algoritmos "que aprendem com os dados, têm capacidades auto-adaptativas e não são explicitamente programados", explicou Marques. É a esta última categoria que pertencem as populares redes neuronais artificiais.

"As neurociências contribuíram de forma inestimável para inspirar o desenvolvimento da IA moderna", sublinhou. Os neurónios são os elementos constitutivos do sistema nervoso, e os neurónios artificiais, de software ou hardware, que simulam a forma como os neurónios biológicos processam a informação, são os elementos constitutivos das máquinas de aprendizagem.

Como é que estes neurónios artificiais aprendem? Marques deu o exemplo de como uma máquina deste tipo pode ser treinada para distinguir melancias de melões. As melancias têm várias características definidas, como a sua cor, peso e tamanho. A rede artificial, que está organizada numa camada (de neurónios) de entrada, numa camada de saída e em várias camadas internas, ou ocultas, recebe estas características numéricas, ou inputs, multiplicadas pela sua importância, ou peso, e dá uma resposta binária conforme um determinado limiar tenha sido atingido ou não: 0 significa Não e 1 significa Sim. Esta resposta é semelhante aos potenciais de ação nos neurónios reais, que disparam ou permanecem em silêncio dependendo de determinadas condições.

Os resultados ou outputs dados pela rede neuronal são então comparados com as respostas esperadas (conforme as características introduzidas sejam efetivamente as de uma melancia ou não) e os erros nas respostas são "retropropagados" para as camadas ocultas da rede neural de forma a corrigir – ou adaptar – os seus parâmetros internos (os pesos associados às diferentes características). Assim, a máquina aprende e melhora o reconhecimento das melancias, por tentativa e erro, durante o treino.

"Mas o que é que o algoritmo da rede neuronal está exactamente a aprender?", perguntou Marques. De facto, através da adaptação dos pesos das características, respondeu, está a aprender representações – neste caso, de melancias versus melões. "Está a aprender melhores formas de representação", vincou.

A primeira rede neural artificial a conseguir aprender desta forma foi o Perceptron, uma retina eletrónica inventada pelo psicólogo norte-americano Frank Rosenblatt, da Universidade de Cornell, em 1958. Mas o Perceptron era muito simples e tinha muitas limitações – e, nas décadas de 1960 e 1970, vários nomes sonantes do domínio da IA, entre os quais Marvin Minsky, do MIT, consideraram que não tinha futuro. A partir daí, os investigadores concentraram os seus esforços nos sistemas periciais da IA tradicional e as redes neuronais passaram por um "inverno" de mais de uma década antes de regressarem à ribalta.

Actualmente, os sistemas periciais continuam a ser utilizados em muitas aplicações, em particular nas finanças e na banca. Um dos mais famosos, como lembrou Marques, foi o programa de xadrez Deep Blue da IBM, que graças ao enorme poder combinatório do seu computador dedicado derrotou o campeão mundial Garry Kasparov em 1996. Mas hoje, são sem dúvida o ChatGPT e os algoritmos de redes neuronais em geral que se tornaram o rosto da IA moderna.

"O debate em torno das redes neuronais [a abordagem conexionista] versus a IA simbólica [sistemas periciais] prolongou-se por várias décadas", observou Marques. "Nos anos 1970, as redes neuronais artificiais não eram muito eficientes." Mas, no final, "houve a necessidade de voltar às redes neuronais".

A introdução de camadas intermédias, a resolução bem sucedida do problema da retropropagação dos erros, o desenvolvimento das chamadas redes neuronais convolucionais (capazes de reconhecer padrões em imagens), "permitiram que as redes neuronais artificiais aprendessem representações mais complexas e realizassem tarefas mais complexas", explicou ainda Marques.

E, no final dos anos 2000, o desenvolvimento das GPUs (Graphic Processing Units), muito mais potentes do que as clássicas CPUs (Central Processing Units) dos computadores, aliado à disponibilidade de enormes conjuntos de dados graças ao advento da World Wide Web e das primeiras redes sociais, foram os avanços necessários para que as redes neuronais artificiais atingissem a maioridade. De tal forma que recentemente, nota Marques, "os próprios neurocientistas começaram a utilizar muitos destes modelos para compreender o funcionamento do cérebro", numa espécie de situação inversa. As redes neuronais ainda têm muitas limitações, concluiu com realismo. Mas é certo que já percorreram um longo caminho.

Durante a terceira e última parte da noite, os CD Ana Maia e Prannay Reddy fizeram perguntas sobre IA a... uma IA chamada Lesly. "As máquinas são mais inteligentes do que nós?", perguntaram. Sessenta e seis por cento dos espectadores responderam "não", mas a opinião de Lesly foi algo diferente: "Depende da forma como definimos a inteligência", ressoou a sua voz. Mas admitiu no entanto que, enquanto máquina, não tinha "ética nem emoções, nem consciência, nem experiências", e que se via a si própria como um complemento da inteligência humana através da cooperação.

A encerrar o evento, os CD evocaram também uma diferença menos frequentemente mencionada, mas essencial, entre uma rede neuronal e um cérebro: "é necessária uma quantidade de energia equivalente ao consumo diário de uma cidade para treinar a Lesly, enquanto nós carburamos com frutos e nozes".

Os dois próximos Eventos Ar, sobre o Presente e o Futuro da IA, terão lugar em Fevereiro e Abril de 2024.

Texto por Ana Gerschenfeld, Health&Science Writter da Fundação Champalimaud.

Fotografias de Carla Emilie Pereira e Catarina Ramos.